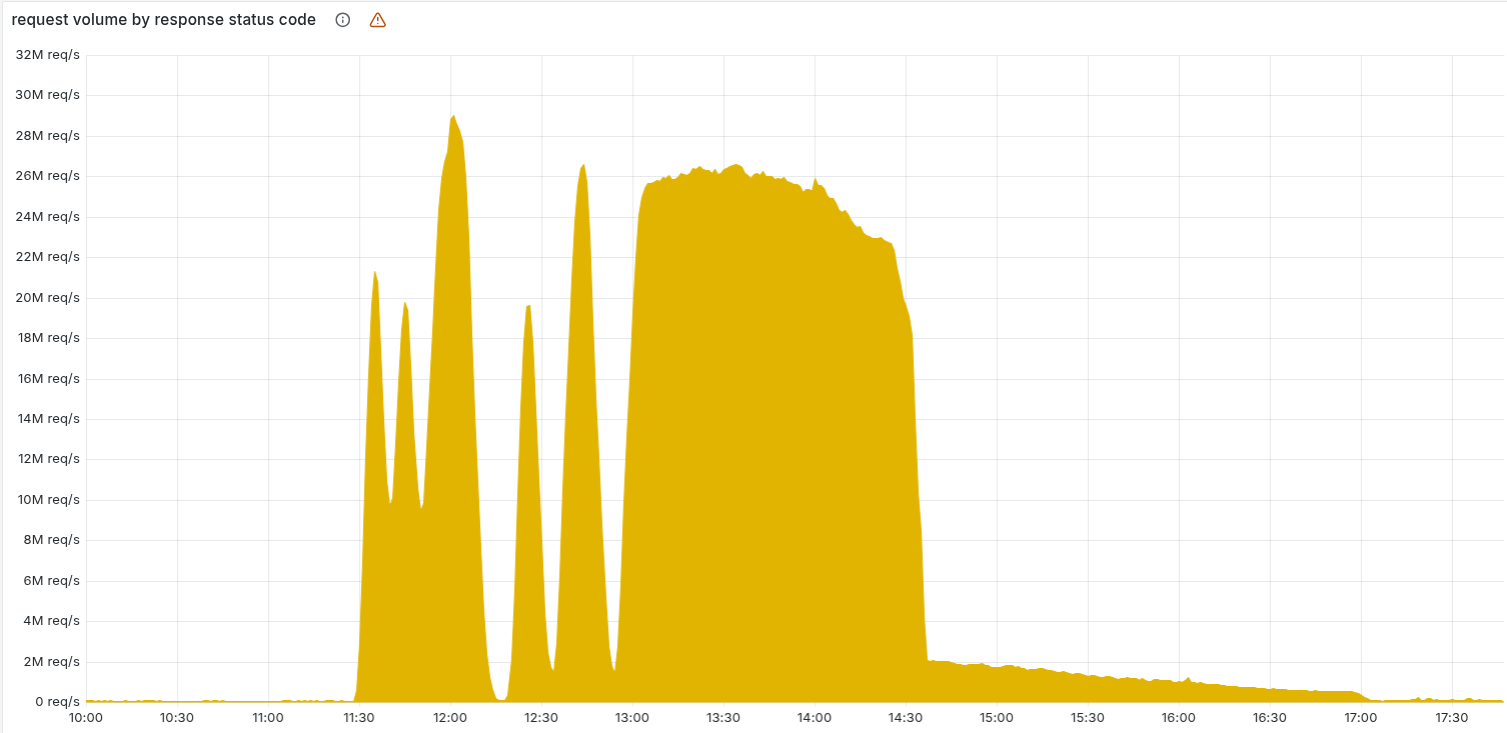

2025 年 11 月 18 日晚,Cloudflare 爆发了一次影响全球的大范围故障。CDN、WAF、Workers、Access 等核心链路集体异常,导致大量网站出现 5xx 错误、登录失败、人机验证异常 等问题。

这不是攻击,也不是 DDoS,而是一起 内部变更引发的连锁反应。😅

🕒 一、事件时间线(含北京时间)

📌 从国内时间来看,这次事故贯穿了当晚黄金时段(感受明显😓,多数网站打不开),一直到凌晨才真正恢复。

🧠 二、事故的根本原因

Cloudflare 的 Bot Management 系统依赖一个 “特征文件” 来判断机器人行为。

这次事故的触发链路如下:

🔧 Cloudflare 调整了 ClickHouse 的数据库权限

📊 查询结果突然出现重复数据

🗂️ 特征文件体积暴涨,超过了 FL / FL2 的加载限制

💥 新版代理直接崩溃;旧版代理虽然不崩但评分全变为 0

🌍 大量边缘节点线程挂掉 → 全球用户看到广泛的 5xx

一句话总结:

上游一个权限变更,引发了下游整个 Cloudflare Edge 的震荡。

这是典型的 “微小调整 → 系统性连锁爆炸” 的复杂系统问题。

📉 三、受影响的 Cloudflare 服务

这次故障几乎覆盖了 Cloudflare 的所有 Edge 产品:

🚫 CDN / WAF: 大量 5xx,很多网站无法访问

⚙️ Workers KV: 读取失败、业务逻辑报错

🔐 Cloudflare Access: 登录失败、策略更新异常

🖥️ Dashboard / Turnstile: 无法登录、验证不稳定

📧 Email Security: 垃圾邮件识别能力下降

📌 实际体验上:

无论企业站点、个人博客还是 API,都在不同程度上受到了影响。

🔧 四、Cloudflare 的应对措施

Cloudflare 的处理较为迅速和“工业化”,主要包含:

🛑 立即停止推送异常特征文件

阻止问题继续扩散。🔙 回滚到正常特征文件版本

让代理恢复可运行状态。📴 为机器人管理系统加入紧急关闭机制

防止未来单个文件异常再触发系统性故障。🛡 强化代理的越界检测与错误处理

包括严格验证、错误日志限制、运行状态保护等。

💬 五、一些值得注意的点

复杂系统永远存在“组合风险”

这次故障不是 Bug,而是“权限调整 + 特征文件系统 + 代理限制”共同触发。

Cloudflare 的透明度依旧行业领先

详细的复盘报告、时间线和责任链路都公开透明。

高度依赖 Cloudflare 的企业应考虑冗余

特别是使用 Access、Workers 作为核心链路的企业。

一旦 Cloudflare 挂了,你的系统会瞬间断电。

对整个行业是一次提醒

互联网基础设施不是“写好代码就万事大吉”。

真正的难点是规模、依赖链和长期演化的架构。

🧩 六、小结

Cloudflare 的 11·18 故障是一场典型的 “小变更 → 大爆炸” 的互联网基础设施事故。

持续近 6 小时,影响范围极大。

这次事件再次证明:

现代互联网的复杂性来自链路,而不是代码本身。

Cloudflare 在修复后开始加强系统级防护,但对于开发者、站点运营者而言,更重要的是:

⚠️ 考虑冗余

⚙️ 分散关键服务

🌐 不要把所有流量、验证、回源都压在一个平台上

评论